微信掃碼咨詢

來源:新智元

【新智元導讀】OpenAI說要改變歷史,他們做到了!今夜的發布會上,‘Her’徹底成真。GPT-4o加持的ChatGPT,和人類的對話絲滑得像個真人,驚掉在場所有觀眾的下巴。眼看著科幻中的設想一件件成真,活在這個奇點臨近的時代,我們何其幸運。

傳說,這一夜,OpenAI要改變歷史。

看完發布會的觀眾們,久久未從巨大的震驚中走出——科幻電影中的‘Her’,在此刻成真了!

在全場歡呼中,CTO Mira Murati走到臺上,為全世界揭曉了OpenAI神秘新產品的面紗——

GPT-4o,在千呼萬喚中登場了。

現場演示中,它的表現仿佛一個人正坐在旁邊,和人類的對話節奏自然、融洽,完全聽不出是個AI。

從今夜之后,人機交互徹底進入新的時代!

這也正呼應著它名字中的玄機:‘o’代表著‘omni’,意味著OpenAI朝著更自然的人機交互邁出了重要一步。

在短短232毫秒內,GPT-4o就能對音頻輸入做出反應,平均為320毫秒。這個反應時間,已經達到了人類的級別!

并且,它可以將文本、音頻、圖像任何組合作為輸入和輸出。

而在英語文本和代碼基準測試中,GPT-4o的性能與GPT-4 Turbo不相上下,并在非英語文本得到顯著改進。

更值得一提的是,這款全新的AI模型,免費向所有人提供GPT-4級別的AI。

(是的,上周在LMSYS模型競技場上引起整個AI圈瘋狂試用的那個gpt2,就是它!)

現在,進入ChatGPT頁面,Plus用戶可以搶先體驗‘最新、最先進的模型’GPT-4o。

Sam Altman親自在x上發起了產品介紹。

Altman介紹道‘GPT-4o是OpenAI有史以來最好的模型,它很聰明,速度很快,是天然的多模態。’

而且,所有ChatGPT用戶都可以使用,完全免費!

Altman特意強調,此前雖然只有按月付費的用戶才能使用GPT-4級別的模型,但這可不是OpenAI的本意哦。

‘我們的初心,就是把最出色的AI工具,交到每個人的手中。’

而即將召開年度I/O大會的谷歌,不甘示弱,也開啟了語音助手的demo實時演示。

谷歌DeepMin的CEO Demis Hassabis激動地表示,自己將首次在I/O大會上演講,并分享他們所做的工作。

兩大巨頭正面剛起來了!明天還有好戲要看,已經聞到硝煙味了。

一夜顛覆語音助手:全新旗艦GPT-4o登場

當然,這次發布會的壓軸主角,就是OpenAI推出的旗艦模型GPT-4o了。

這個帶著光環登場的模型,其最大意義就在于,把GPT-4級別的智能,帶給了OpenAI的每一位用戶!

從此以后,無論你是付費用戶,還是免費用戶,都能通過它體驗GPT-4了。

唯一不同的是,ChatGPT Plus的消息限制是免費用戶的5倍。

并且,GPT-4o不僅提供與GPT-4同等程度的模型能力,推理速度還更快,還能提供同時理解文本、圖像、音頻等內容的多模態能力。

注意,GPT-4o接下來要放大招了。

實時語音對話:ChatGPT完美變身Moss

研發負責人Mark Chen首先展示的,是全新ChatGPT的關鍵功能之一——實時語音對話。

他向它問道:‘我正在臺上,給大家做現場演示呢,我有點緊張,該怎么辦呀?’

ChatGPT非常體貼地表示:‘你在臺上做演示嗎,那你真的太棒了!深呼吸一下吧,記得你是個專家!’

Mark瘋狂地大喘氣幾次,問ChatGPT能給自己什么建議嗎。(此處全場笑聲)

它驚訝地說道:‘放松啊Mark,慢點呼吸,你可不是個吸塵器!’(它的幽默感,也再次引起全場哄笑)

注意,在這個過程中,ChatGPT和Mark的互動幾乎無延遲,隨時接梗,共情能力滿分。

而且,模型能夠理解人類在對話中適時‘打斷’的習慣,會及時停下來聽你說話,并給出相應的回復,而且也不會‘斷片’。

比如,Mark表示自己要再試一遍深呼吸,此時ChatGPT也恰到好處地插進來接話說‘慢慢呼氣’。

整個過程,自然連貫得仿佛它是個坐在你對面的人類,完全沒有AI的機械感和僵硬感!

相比反應遲鈍、沒法打斷還缺少情商的Siri等語音助手,這局ChatGPT完勝。

這,才是人類最理想AI語音助手的樣子啊,Moss果然成真了!

不僅如此,ChatGPT的‘高情商’也讓觀眾們驚呼太頂了!

對話中,它可以聽懂用戶說話時不同的語調、語氣,還能根據自己的臺詞生成不同語氣的語音,完全沒有‘機械感’。

扮演不同角色,給任性的人類講睡前故事

接下來,ChatGPT被要求講一個睡前故事,主題是‘戀愛中的機器人’。

ChatGPT沒講幾秒,就被人類粗暴地打斷了:‘多點情緒,故事里來點戲劇性行不?’

ChatGPT表示ok,用更起伏的聲調、更夸張的語氣開始講起了故事。

結果沒幾秒,它又被再次打斷:‘不行不行,再多點情感,給我最大程度的表達可以嗎?’

接下來,我們聽到一個仿佛在舞臺上表演莎劇的ChatGPT,語氣夸張到仿佛是個戲劇演員。

隨后,它又多次被打斷,并且耐心地按照人類的要求,依次變成了機器人聲和唱歌模式。

ChatGPT聽到要求自己唱歌時,甚至嘆了口氣,然后開始亮起了優美的歌喉。

這也就是ChatGPT脾氣好,要是真人,估計要被暴打了。不過它無奈嘆氣的那個瞬間,一瞬間的確san值狂掉——真的好像人啊!

視頻實時互動解方程

秀完情商,ChatGPT要開始秀智商了。

下一個任務,另一位研發負責人Barret手寫了一個方程,并打開攝像頭拍給ChatGPT,讓它扮演‘在線導師’的角色幫助自己解題,而且只能給提示,不能直接說答案。

接到任務的ChatGPT,甚至開心大叫:‘Oops,我好興奮啊!’

小哥在紙上寫下這樣一個方程:3x+1=4。然后問ChatGPT自己寫的是什么方程,ChatGPT語調自然地回答出來了。

隨后,在小哥的要求下,它一步一步說出了解題步驟。

最厲害的是,隨著小哥在攝像頭中解題,ChatGPT實時地就給出了鼓勵和引導。

而且可怕的是,時間上沒有絲毫延遲,這邊人還在算呢,那邊就實時給出了評價和反饋。(說背后沒藏個人還真不信呢)

想起之前谷歌剪輯版的Gemini演示,這對比之下真是打臉啪啪的啊。

當被問到‘學習線性方程在生活中有什么用’這樣的問題時,ChatGPT還會舉出實際的例子對你‘循循善誘’:

這是個不錯的問題,雖然我們沒有注意到,但線性方程在每天的生活中都會出現,比如計算花銷、規劃旅行、烹飪,甚至在商業中進行盈虧計算。這基本上是解決問題的一種方式,你需要找到一個未知變量......

不僅言之有物,而且態度及其和藹,說話說到一半被打斷時都不會生氣。

方程的任務告一段落,兩人還現場來了一波表白——在紙上寫下‘我

ChatGPT看到后,驚喜又害羞地說:‘哦,你竟然說愛我,你太可愛了!’

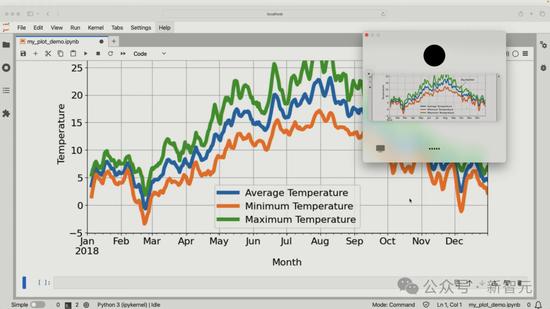

桌面版ChatGPT秒解代碼難題

解方程任務也許還不能充分展現ChatGPT的能力,于是OpenAI又上了一波難度——看代碼,并進行簡短描述。

模型幾乎是立即理解了代碼,并給出了絲滑且完整的描述。

比如準確對應了函數名及其功能,并識別出了其中取平均值、最高值等操作的意圖。

當被問到‘如果沒有foo這個函數,繪制的圖表會是什么樣子’,ChatGPT也立即做出了正確回復,可見已經完美理解了代碼中的內在邏輯。

接下來,ChatGPT還被要求概述代碼生成的圖表,并回答用戶問題。

不出意外,圖表中各方面的關鍵信息也都被ChatGPT精準捕捉到了,包括x、y軸的信息與范圍、數據標注的含義等。

隨后Mark提出的問題是‘你看到哪個月的氣溫最高?對應的最高氣溫大概是多少?’

這種能作為學校數學考試題目的圖表理解任務,ChatGPT解決起來也幾乎沒有障礙,還能像接受面試一樣實時回答你的問題。

直播觀眾提問:給你看看我的自拍

模型演示之后,還有彩蛋。

發布會在線上同步直播,于是主持人收集了一些推特網友的提問,并且當場展示。

這可以說是比演示更加刺激的環節,在沒有準備和彩排的情況下,這可是真刀真槍地檢驗模型實力了。

第一位網友的提問是‘GPT-4o是否具有實時翻譯功能?’

隨后,在Mark的任務定義下,ChatGPT完成了將英語‘同聲傳譯’為意大利語的任務。

第二位網友的提問是‘模型可以只通過我的表情識別情緒嗎?’

研發負責人Barett也沒在怕,拿起手機就照了一張自拍,甩給了ChatGPT,問道‘我現在是什么情緒呢?’

ChatGPT不知是幽默了一把還是翻車了,說‘我好像在看一個木質表面的東西’。

見勢不好,Barett匆忙打斷。他在提示工程方面也是經驗頗深,一句話就將對話拉回正軌:‘那是我之前發給你的的東西,不用擔心,我不是一張桌子’。

ChatGPT表示,啊,這就對了嘛。再次引起全場哄笑。這次它給出了非常‘人性化’的正確答案——

‘看起來你非常開心快樂,帶著大大的笑容,可能甚至有一點興奮。無論正在發生什么事,似乎你心情很好,愿意分享一下有什么高興事嗎?’

Barett順勢表示:‘我開心的原因是我們正在做演示,你的表現很棒。’

受到夸獎的ChatGPT居然很風趣地來了一句‘哦,別說了,你都讓我臉紅了’,再次逗笑了全場。

Greg Brockman親自演示

除了發布會上的現場演示之外,OpenAI總裁Greg Brockman也親自下場,在網上發布了一段自己使用ChatGPT各種功能的視頻。

GPT-4o強在哪兒?

在過去幾年里,OpenAI一直在專注于提升模型的智能水平。

雖然后者已經達到了一個相當的水平,但是,今天這是第一次,模型在易用性方面,邁出了一大步!

為什么會把模型的易用性提到如此戰略層面的高度?這是因為,即使一個AI再強大,如果它不能和人有效互動,也就失去了意義。

在這個過程中,OpenAI所著眼的,是人類和機器交互的未來。

而今天GPT-4o的發布,可能會成為一個分水嶺,讓人機協作的范式徹底邁入一個新階段!

為此,OpenAI希望把GPT-4o和人類的互動,打造得格外舒服自然。

不過,雖然這個理想很宏大,但是在實際操作過程中,卻遭遇了不小的困難。

毫秒級響應,與人類對話一致

首先,在人類之間互動時,有很多東西是我們認為理所當然的,但要讓AI理解這些,就變得很困難。

比如,我們的談話經常被打斷,談話過程中會有背景噪聲,會有多個人同時說話的情況,說話人的語氣語調也經常發生微妙的變化。

OpenAI克服了很大困難,花費了數月的時間,終于打造出了完美適應這些狀況的GPT-4o!

在GPT-4o發布之前,通過語音模式(Voice Mode)與ChatGPT對話,平均延遲為2.8秒(GPT-3.5)和5.4秒(GPT-4)。

當時,為了實現這一點,‘語音模式’設有三個獨立模型的管線:

- 一個簡單模型將音頻轉錄成文本

- GPT-3.5或GPT-4接收文本并輸出文本

- 第三個簡單模型將文本轉換回音頻

這一過程走下來,意味著主要的智能來源GPT-4就丟失了很多信息:

不能直接觀察語氣、多位說話者或背景噪音,也無法無法輸出笑聲、歌聲或表達情感。

而這也導致了延遲,大大破壞了我們和ChatGPT協作的沉浸感。

但現在,GPT-4o讓一切都發生得很自然。

它能以平均320毫秒,做出響應。

它可以跨越語音、文本、視覺多種形式,直接進行推理!

GPT-4o是OpenAI首個端到端訓練的跨越文本、視覺和音頻的新模型,意味著所有輸入和輸出都由相同的神經網絡處理。

這就會徹底顛覆ChatGPT 1億用戶的工作和生活。

不僅如此,由于GPT-4o是‘原生的多模態’,自然地集成了語言、視覺和音頻等多種能力。

用戶可以上傳各種圖片、視頻,以及包含圖片和文字的文檔,討論其中的內容。

GPT-4o也內置了搜索功能,可以實時搜索網頁信息來回復用戶。

相比ChatGPT,GPT-4o的記憶能力更是提升了不少,不僅在對話中可以記住你提過的問題,還能記住你們之間的所有對話,提供‘連續感’。

更高級的是,新版模型還具備了數據分析能力,可以理解并分析用戶上傳的數據和圖表。

而且,為了真正實現‘讓AGI惠及全人類’的愿景,GPT-4o有50種語言的版本,并改進了推理的質量和速度,這也就意味著,全球97%的人口都可以使用GPT-4o了!

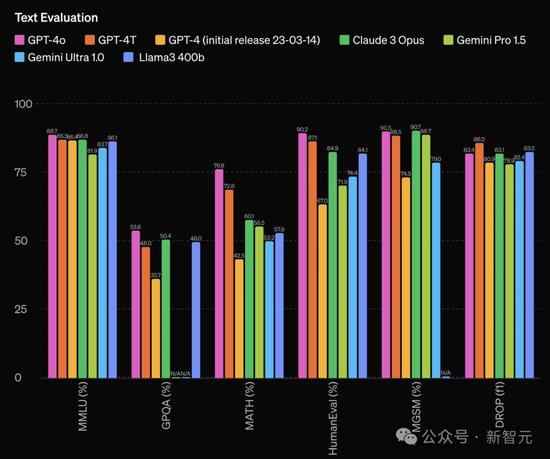

GPT-4o刷新SOTA,擊敗‘開源GPT-4’還免費用

GPT-4o的具體性能表現如何?

接下來的圖表中,可以看到,OpenAI對此前所有堪稱超越GPT-4版本的模型,做出了統一回應:

We‘re so back!

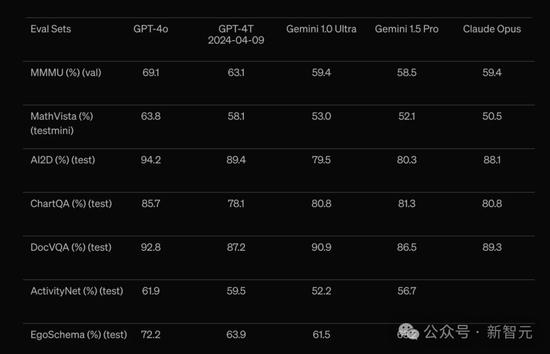

在傳統基準測試中,GPT-4o在文本、推理和編碼智能方面,達到了GPT-4 Turbo級別的性能,同時在多語言、音頻和視覺能力方面創下了新高。

如下是,在文本評估中,GPT-4o幾乎碾壓一眾模型,包括Claude 3 Opus,Gemini Pro 1.5,甚至是‘開源版GPT-4’Llama 3 400B。

GPT-4o在零樣本的COT MMLU(常識問題)上創造了88.7%的新高分。

與傳統的5個樣本,沒有使用COT的MMLU評測中,GPT-4o更是創下了87.2%的新高分!

不過在DROP中,GPT-4o的表現稍落后于GPT-4 Turbo。

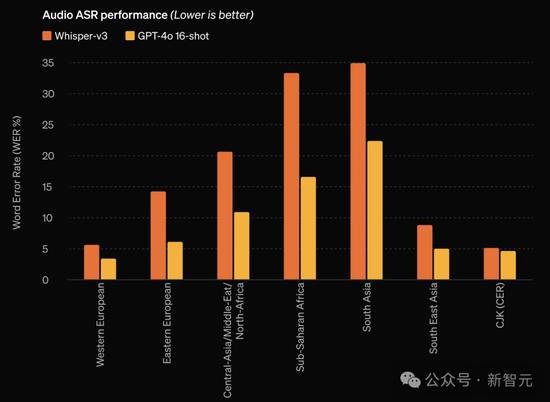

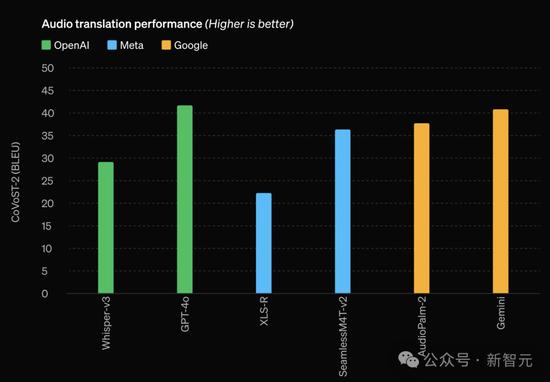

在音頻ASR表現上,比起Whisper-v3 ,GPT-4o顯著提高了所有語言的語音識別性能,尤其是對資源較少的語言。

再來看音頻翻譯能力,GPT-4o刷新SOTA,并在MLS基準上超過了Whisper-v3。

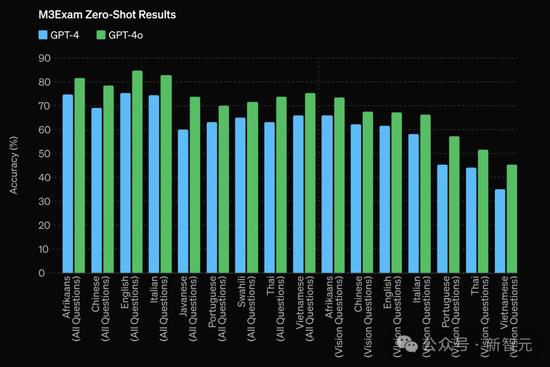

另外,OpenAI團隊還對最新模型GPT-4o在M3Exam基準上進行了測試。

這是一種多語言和視覺評估基準,由來自其他國家標準化測試的多項選擇題組成,有時還包括數字和圖表。

結果如下表所示,在所有語言的測試中,GPT-4o都比GPT-4強。

(在此,省略了Swahili和Javanese兩種語言的視覺結果,因為這些語言只有5個或更少的視覺問題。)

最后,在視覺理解基準EVALS評估上,GPT-4o也取得了領先的性能。

同樣,擊敗了GPT-4 Turbo、Gemini 1.0 Ultra、Gemini 1.5 Pro,以及Claude 3 Opus。

ChatGPT免費用戶,可以訪問的功能

OpenAI官博還介紹了,ChatGPT免費用戶可以訪問新模型加持下的功能,包括:

- 體驗GPT-4級別的智能

- 從聯網后的模型得到響應

- 分析數據并創建圖表

- 暢聊你拍的照片

- 上傳文件以幫助總結、撰寫或分析

- 發現和使用GPTs和GPT Store

- 用記憶構建更有用的體驗

比如,你拍一張照片發給ChatGPT,然后問‘這個食物的營養價值是什么’?

ChatGPT瞬間做出響應,解釋了牛角包的營養價值。

免費用戶還可以體驗到聯網搜索的快樂。(當然是最新最強模型)

‘幫我推薦達拉斯5個適合夜晚約會的餐廳’。

ChatGPT通過搜索3個網站,立即總結出了你想要的結果。

另外,免費福利還包括,在GPT商店中使用模型。

API速度飆升2倍,再打骨折

此外,讓開發者興奮的是,GPT-4o不僅應用在ChatGPT服務中,模型的API也被同步放出,可以部署各種下游應用程序上。

同時,API的性能也有所改進,據說相比GPT-4 Turbo,推理速度提升2倍,消息限制提高五倍,而且價格還會降低50%。

OpenAI開發者在線呼吁,趕快來體驗。

ChatGPT桌面版也來了

正如Murati一出場開宗明義的:對OpenAI來說,打造一款真正讓所有人可用的產品,非常之重要。

為了讓每個人無論身在何處,都能隨時用上ChatGPT,OpenAI發布了ChatGPT的桌面版本。

它擁有桌面應用程序,和全新的用戶界面,可以很輕易地和我們的工作流融為一體。

只需一個簡單的快捷鍵——Option+空格鍵,就可以立即召喚桌面版ChatGPT。

甚至,你也可以直接在應用程序中截圖,并進行提問。

然后,讓其幫你總結所截取的網頁內容——‘將其總結成5個主題,并列出行動計劃’。

接下來,ChatGPT一通炫技,嗖嗖嗖地解決了提出的問題。

你甚至,可以從你的電腦上直接與ChatGPT進行語音對話,點擊桌面應用程序右下角的耳機圖標,便可開始。

同時,OpenAI還全面改版了UI界面,讓它和用戶的互動也變得更自然,更簡單了。

神秘gpt2就是GPT-4o!

‘這么厲害的GPT-4o,早已是你們的老熟人了’,ChatGPT官方賬號在線賣起關子。

這,究竟是怎么回事?

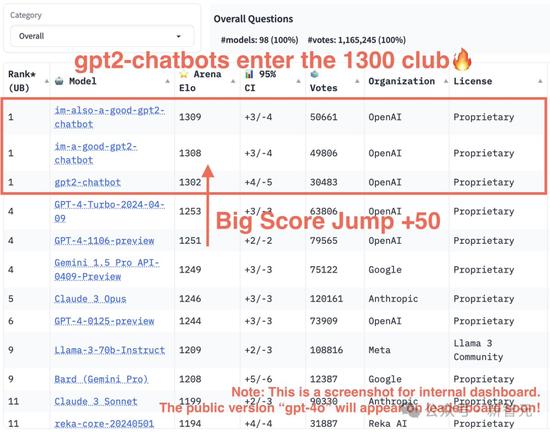

幾天前,大模型LMSYS競技場上,一個名為gpt2神秘模型突然現身,其性能甚至超越了GPT-4。

注:最初以gpt2命名,現在升級為兩個版本‘im-also-a-good-gpt2-chatbot’和‘im-a-good-gpt2-chatbot’

全網紛紛猜測,這個模型,可能就是GPT-4.5/GPT-5。

就連Altman本人多次發貼,暗示gpt2的強大能力——

如今,gpt2的身份,真的解密了。

OpenAI研究科學家William Fedus剛剛發文, 一直在測試的版本‘im-also-a-good-gpt2-chatbot’就是GPT-4o。

以下是它一直以來的表現。

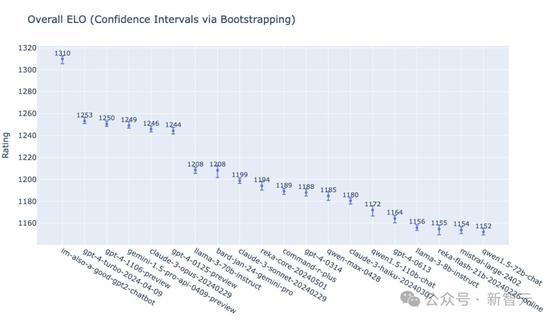

im-also-a-good-gpt2-chatbot總ELO得分,超過了最新的gpt4-turbo-2024-04-09。

但ELO最終得分,會受到‘提示’難度的限制(即無法在類似‘你好嗎’這種簡單提示上取得任意高的勝率)。

OpenAI團隊發現,在更難的提示集合上——尤其是編程方面——存在更大的差距:

而GPT-4o在我們此前的最佳模型上,ELO甚至可以提高100分。

最關鍵的是,GPT-4o不僅是全世界最好的模型,甚至可以在ChatGPT中免費用。

另一邊,LMSYS發布了最新的gpt2-chatbots結果,已經躍升至大模型競技場榜首!

奧特曼對此大贊,‘令人驚嘆的工作’!

OpenAI聯創Greg Brockman表示,‘初步的指標看起來很有前景’。

接下來,就看明天谷歌I/O大會上的表現了。

13560189272

13560189272  地址:廣州市天河區黃埔大道西201號金澤大廈808室

地址:廣州市天河區黃埔大道西201號金澤大廈808室